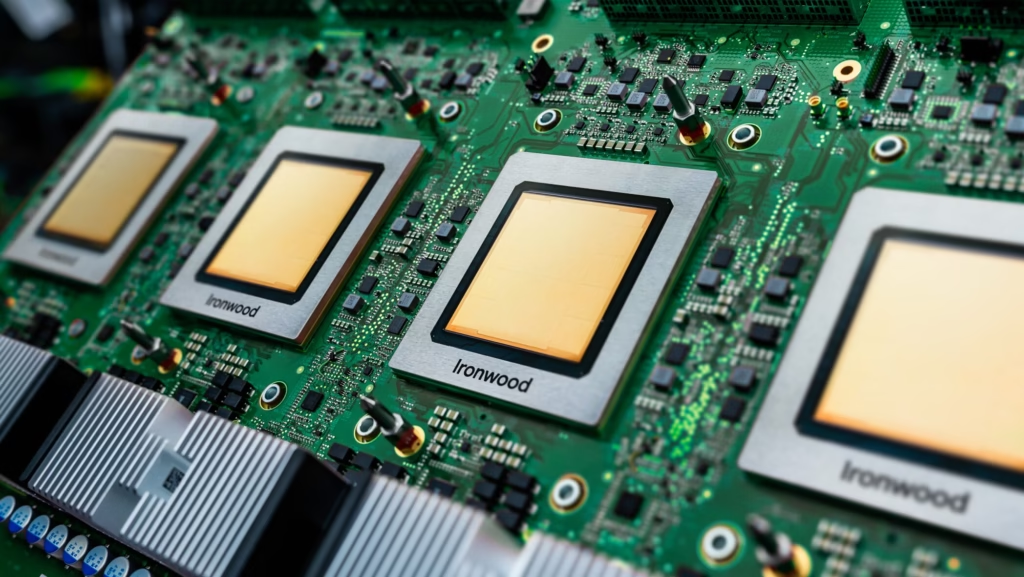

L’histoire de l’informatique vient peut-être de franchir son Rubicon, non pas avec un nouveau modèle de langage qui écrit de la poésie, mais avec un morceau de silicium. Google Ironwood, la puce TPU de 7e génération tout juste dévoilée, n’est pas seulement une bête de course pour l’infrastructure cloud. C’est la première preuve tangible d’une boucle technologique fermée : une puce conçue par une intelligence artificielle pour exécuter des intelligences artificielles plus puissantes. Si vous cherchiez le moment exact où la machine a commencé à s’auto-améliorer physiquement, ne cherchez plus. Ironwood est là, et les implications pour l’industrie sont vertigineuses.

Le mur de la complexité humaine

Pendant des décennies, la conception de puces (le floorplanning) a été l’apanage d’ingénieurs humains ultra-spécialisés, déplaçant des blocs de mémoire et de logique comme des pièces de Tetris infiniment complexes. Mais avec des transistors se comptant en milliards et la fin de la loi de Moore telle que nous la connaissions, l’esprit humain est devenu le goulot d’étranglement.

Google a vu ce mur arriver. C’est pourquoi Ironwood n’est pas né sur une planche à dessin classique, mais dans les réseaux neuronaux d’AlphaChip (anciennement connu sous le nom de méthodes d’apprentissage par renforcement de DeepMind). Le résultat ? Une architecture que des humains auraient mis des mois à optimiser, générée en quelques heures, avec une efficacité énergétique et une densité de calcul qui défient les standards actuels.

Ironwood (TPU v7) : Les chiffres du vertige

Alors, qu’est-ce que cette « conception inorganique » apporte concrètement à vos workloads IA ? Les spécifications techniques révélées cette semaine sont, pour le dire simplement, brutales pour la concurrence.

Une puissance de feu quadruplée

Ironwood affiche une performance par puce 4 fois supérieure à celle de la génération précédente (Trillium / TPU v6) pour les tâches d’entraînement et d’inférence. Mais le chiffre le plus effrayant pour les rivaux de Mountain View réside dans l’échelle : un seul « Pod » Ironwood peut désormais contenir 9 216 puces interconnectées, délivrant une puissance de calcul théorique de 42,5 Exaflops.

Pour vous donner une échelle : c’est environ 24 fois la puissance brute d’El Capitan, l’un des supercalculateurs les plus puissants au monde, concentrée dans une seule grappe de serveurs dédiée à l’IA.

L’ère de l’inférence reine

Contrairement aux générations précédentes (v4, v5p) qui étaient obsédées par l’entraînement des modèles (le training), Ironwood marque un pivot stratégique vers l’inférence.

Pourquoi ce changement ? Parce que vous n’entraînez pas Gemini 3 tous les matins, mais vous l’interrogez des millions de fois par seconde. Google a optimisé Ironwood pour réduire la latence et la consommation d’énergie lors de l’utilisation active des modèles. C’est une puce conçue pour « penser » en temps réel, pas juste pour « apprendre ».

AlphaChip : Quand l’IA joue aux LEGOs divins

C’est ici que l’annonce devient fascinante sur le plan conceptuel. Ironwood est le fruit de la méthode AlphaChip. Google traite la conception physique de la puce comme un jeu.

Imaginez un plateau de jeu où les pièces sont des composants logiques (mémoire, contrôleurs, unités de calcul) et le but est de minimiser la longueur des fils tout en maximisant la vitesse. AlphaChip utilise l’apprentissage par renforcement pour jouer à ce jeu des millions de fois, apprenant des stratégies de placement « surhumaines » qui échappent à la logique intuitive des ingénieurs.

Ce qui est terrifiant – ou génial, selon votre position –, c’est que plus AlphaChip conçoit de puces, plus elle devient performante pour concevoir la suivante. Ironwood a été optimisé en apprenant des erreurs et des succès de Trillium. Nous assistons à l’accélération de l’accélération.

Analyse : La forteresse Google se referme

Cette annonce n’est pas anodine dans la guerre froide des semi-conducteurs qui oppose Google, Nvidia et AMD.

1. L’avantage de l’intégration verticale

En utilisant ses propres IA pour concevoir ses propres puces qui feront tourner ses propres IA, Google s’affranchit des contraintes des outils de conception tiers (EDA) comme Synopsys ou Cadence pour ses cœurs les plus critiques. Cela leur permet d’itérer à une vitesse que Nvidia, qui doit vendre des puces généralistes à tout le monde (de Microsoft à Meta), aura du mal à égaler sur des workloads spécifiques comme les modèles Gemini.

2. Le risque de la « Black Box »

Il existe cependant un risque inhérent à laisser l’IA tenir le crayon. Si AlphaChip génère un layout que les ingénieurs humains ne comprennent pas intuitivement (ce qui arrive déjà, avec des placements de composants qui semblent illogiques mais s’avèrent thermiquement efficients), comment déboguer le hardware en cas de faille physique rare ? Nous entrons dans une ère où nous devrons faire confiance à la machine pour construire la machine.

3. La réponse de l’industrie

Ne vous y trompez pas, Nvidia utilise aussi l’IA pour améliorer ses GPU Blackwell et Rubin (via sa plateforme cuLitho). Mais l’approche de Google avec Ironwood semble plus radicale dans son utilisation du reinforcement learning pour repenser l’architecture physique même, plutôt que de simplement optimiser la lithographie.

Conclusion : La boucle est bouclée

Avec Ironwood, Google ne lance pas seulement un produit, ils valident une méthodologie. C’est la démonstration que l’IA est le seul outil capable de construire l’infrastructure nécessaire à sa propre croissance future. Pour les développeurs et les entreprises utilisant Google Cloud, cela signifie bientôt des instances moins chères et plus rapides pour vos applications d’IA générative. Pour le reste du monde, c’est un signal : l’architecte de demain est un algorithme.